¿Entiende la IA como nosotros? Una nueva métrica desarrollada por el MIT y Harvard lo revela

Investigadores del MIT y de la Universidad de Harvard crean una métrica para evaluar si la inteligencia artificial comprende el mundo como lo entendemos los humanos, un paso clave para su desarrollo.

¿Alguna vez has charlado con un asistente virtual y te ha sorprendido lo bien que responde, pero luego falla estrepitosamente con algo súper básico? La inteligencia artificial (IA) puede parecer súper lista, pero a veces —y en base a algunas de sus respuestas— nos preguntamos si realmente entiende el mundo como lo hacemos nosotros.

Investigadores del MIT y de Harvard están tratando de responder esta pregunta con una nueva herramienta: una métrica que mide si las IA, especialmente los modelos de lenguaje como los que usan chatbots, tienen una comprensión profunda del mundo o solo son buenos imitando patrones.

Pensemos en la IA como un estudiante que memoriza todo para un examen, pero no siempre capta el "porqué" de las cosas. Este trabajo, liderado por expertos como Keyon Vafa, miembro de la International Conference on Machine Learning (ICML), busca ir más allá de las apariencias y descubrir si estos modelos construyen un "mapa mental" del mundo, algo que los humanos hacemos para navegar la realidad. Su propuesta no solo es fascinante, sino que podría cambiar la forma en que diseñamos y cómo usamos la IA en el futuro.

¿Qué es entender como humano?

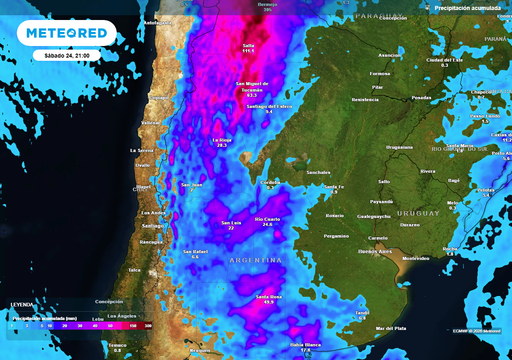

Entender el mundo como humanos implica no solo predecir qué pasa, sino saber por qué pasa. Por ejemplo, si ves que el cielo se nubla, no solo adivinas que lloverá, sino que entiendes que las nubes llevan agua y que ciertos patrones climáticos causan lluvia.

Los investigadores de MIT y Harvard querían saber si los modelos de lenguaje, como los que impulsan a ChatGPT,tienen este tipo de comprensión. Para eso, crearon una métrica que prueba si la IA puede construir un "modelo del mundo", es decir, una representación interna de cómo funcionan las cosas.

En su estudio, usaron un experimento con un mapa virtual de calles, como si la IA fuera un taxista navegando una ciudad. Le dieron datos para que predijera rutas, pero luego cambiaron las reglas, como cerrar una calle. Si la IA entendiera las reglas de la ciudad como un humano, podría adaptarse fácilmente.

Sin embargo, los resultados mostraron que, aunque la IA acertaba mucho al principio, su precisión caía en picada con pequeños cambios, ¡de casi 100% a solo 67% cuando cerraban el 1% de las calles! Esto sugiere que la IA no "entiende" las reglas, solo memoriza patrones.

Un paso hacia una IA más confiable

La métrica propuesta por los investigadores es como un examen para ver si la IA realmente capta la lógica detrás de los datos, no solo si da respuestas correctas. Es un poco como distinguir entre un loro que repite frases y un amigo que explica por qué algo es cierto.

Esta herramienta podría ayudar a que las IA sean más confiables en tareas críticas, como en medicina o conducción autónoma, donde adaptarse a cambios inesperados es vital.

El estudio también abre la puerta a mejorar cómo diseñamos la IA. Si sabemos que los modelos actuales no construyen modelos del mundo robustos, podemos enfocarnos en entrenarlos para que "piensen" más como humanos, captando las causas y no solo los efectos. Esto es clave para aplicaciones donde no basta con predecir, sino que se necesita entender, como en investigaciones científicas o en sistemas que tomen decisiones éticas.

Esta métrica es un gran avance para medir la inteligencia de la IA y acercarla a cómo pensamos los humanos. Aunque las IA actuales son impresionantes, aún están lejos de entendernos del todo. Con herramientas como esta, estamos un paso más cerca de crear máquinas que no solo imiten, sino que comprendan el mundo, haciendo que su uso sea más seguro y útil para todos.

Referencias de la noticia

- MIT News. (2025). Can large language models figure out the real world?

- Vafa, K., et al. (2025). Do Large Language Models Have Consistent Values? ICML 2025.