Rostros que engañan: un breve entrenamiento mejora la detección de caras creadas por inteligencia artificial

Un estudio británico revela que incluso los expertos tienen dificultades para identificar rostros generados por IA, pero una capacitación de apenas cinco minutos mejora notablemente los resultados y abre nuevas estrategias para combatir fraudes digitales.

Los generadores de imágenes basados en inteligencia artificial han avanzado a una velocidad sorprendente. En apenas unos años, lograron crear rostros humanos tan detallados y convincentes que, para muchas personas, resultan incluso más realistas que las caras reales. Este progreso tecnológico plantea un desafío creciente: ¿cómo distinguir una imagen auténtica de una creada por algoritmos?

Un nuevo estudio realizado por investigadores del Reino Unido propone una posible respuesta. La clave estaría en combinar habilidades humanas excepcionales con un entrenamiento breve y específico. Según los resultados, esta estrategia podría fortalecer de manera significativa la detección de rostros generados por IA, una capacidad cada vez más necesaria en un mundo atravesado por fraudes digitales y desinformación.

Superreconocedores frente a personas comunes

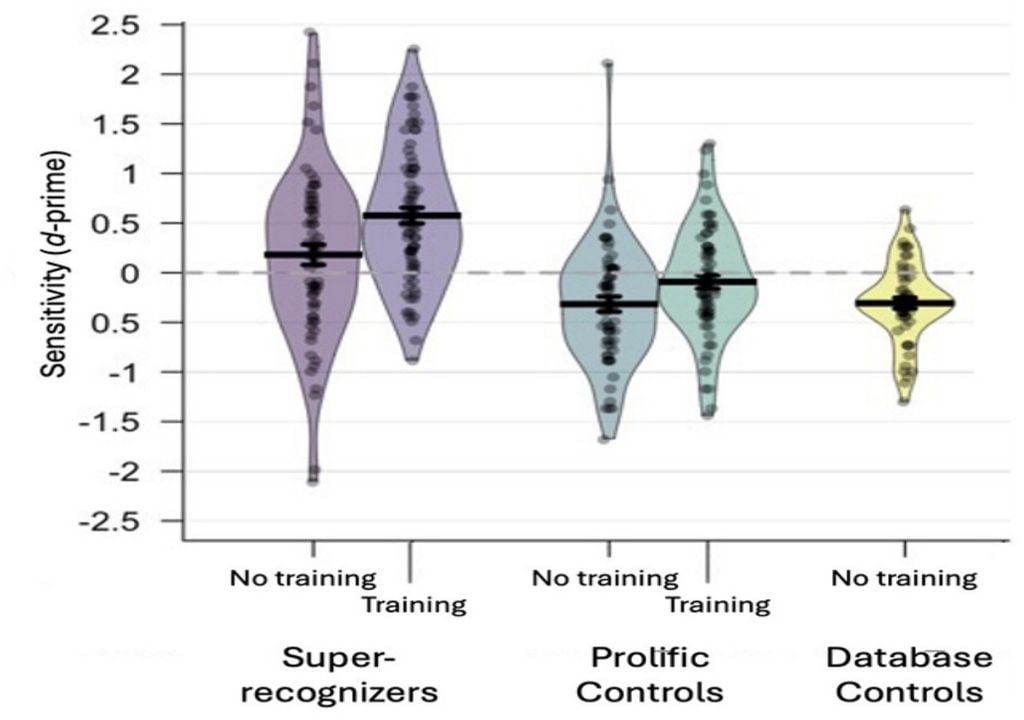

La investigación evaluó a 664 voluntarios divididos en dos grandes grupos. Por un lado, los llamados superreconocedores, personas que en estudios previos demostraron una capacidad sobresaliente para identificar y comparar rostros humanos. Por otro, participantes con habilidades típicas de reconocimiento facial.

Ambos grupos fueron sometidos a pruebas para diferenciar imágenes reales de caras generadas por inteligencia artificial. Los resultados iniciales mostraron que, aunque los superreconocedores se desempeñaron mejor que el promedio, incluso ellos encontraron grandes dificultades para detectar las imágenes falsas.

“El problema es que las imágenes creadas por IA son cada vez más fáciles de producir y cada vez más difíciles de identificar”, explicó Eilidh Noyes, investigadora en psicología de la Universidad de Leeds y una de las autoras del estudio. “Esto las vuelve potencialmente peligrosas desde el punto de vista de la seguridad”.

Dos pruebas, un mismo desafío

El estudio incluyó dos tipos de tareas distintas. En la primera, los participantes veían una sola imagen de un rostro y debían decidir si era real o generada por IA. En la segunda, se les mostraba un par de imágenes —una real y otra artificial— y se les pedía identificar la falsa. Cada experimento contó con un grupo diferente de voluntarios.

Entre quienes no recibieron ningún tipo de entrenamiento previo, los superreconocedores identificaron correctamente las caras generadas por IA en el 41 % de los casos. Las personas con habilidades típicas apenas alcanzaron un 31 % de aciertos. Dado que la mitad de las imágenes eran falsas, estos porcentajes se acercan peligrosamente al azar, lo que confirma lo convincente que puede resultar un rostro artificial.

El impacto de cinco minutos de entrenamiento

La diferencia más notable apareció cuando se incorporó una breve capacitación previa. En este caso, los participantes recibieron un entrenamiento de apenas cinco minutos, enfocado en detectar señales características de las imágenes creadas por IA.

Entre las pistas enseñadas se encontraban detalles sutiles como dientes faltantes, inconsistencias en la textura de la piel o un desenfoque extraño en los bordes del cabello y el rostro. Tras esta preparación, los resultados cambiaron de forma significativa.

Las personas con habilidades típicas lograron identificar imágenes falsas con un 51 % de precisión, un nivel similar al azar. Sin embargo, los superreconocedores aumentaron su efectividad hasta un 64 %, superando ampliamente el umbral de la casualidad.

“Nuestro estudio demuestra que la combinación de superreconocedores y entrenamiento puede ser una herramienta útil para detectar rostros generados por IA”, sostuvo Noyes.

Un problema con implicancias reales

La tecnología detrás de estas imágenes se basa en las llamadas redes generativas antagónicas (GAN, por sus siglas en inglés), sistemas en los que dos algoritmos compiten entre sí: uno crea imágenes y el otro evalúa cuán realistas resultan en comparación con rostros humanos reales. Este proceso de retroalimentación constante permite alcanzar resultados cada vez más creíbles.

“Nuestro procedimiento de entrenamiento es breve y fácil de implementar”, señaló Katie Gray, investigadora de la Universidad de Reading. “Los resultados sugieren que, combinado con las capacidades naturales de los superreconocedores, podría ayudar a enfrentar problemas del mundo real, como la verificación de identidades en línea”.

En un entorno digital donde la apariencia ya no garantiza autenticidad, este tipo de investigaciones ofrece una señal de alerta y, al mismo tiempo, una posible vía de defensa.

Referencia de la noticia

Katie L. H. Gray, Josh P. Davis, Carl Bunce, Eilidh Noyes, Kay L. Ritchie; Training human super-recognizers’ detection and discrimination of AI-generated faces. R Soc Open Sci. 1 November 2025; 12 (11): 250921. https://doi.org/10.1098/rsos.250921